业界首个,阿里通义万相“首尾帧生视频模型”开源

作者:方泰攻略站时间:2025-04-19 23:22:23

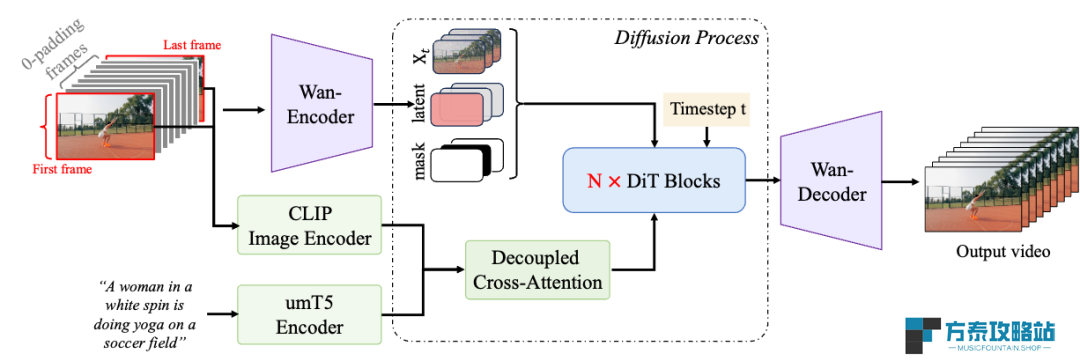

本站 4 月 17 日消息,阿里通义万相「首尾帧生视频模型」今日宣布开源,该模型参数量为 14B,号称是业界首个百亿参数规模的开源首尾帧视频模型。

它可根据用户指定的开始和结束图片,生成一段能衔接首尾画面的 720p 高清视频,此次升级将能满足用户更可控、更定制化的视频生成需求。

用户可在通义万相官网直接免费体验该模型,或在 Github、Hugging Face、魔搭社区下载模型本地部署后进行二次开发。

技术介绍

首尾帧生视频比文生视频、单图生视频的可控性更高,但这类模型的训练难度较大,首尾帧视频生成需同时满足以下几点:

1. 生成的视频内容要保证和用户输入的两张图像一致

2. 能够遵循用户的提示词指令

3. 能从给定的首帧自然、流畅过渡到尾帧

4. 视频本身动作协调、自然

训练及推理优化

基于现有的 Wan2.1 文生视频基础模型架构,通义万相首尾帧生视频模型进一步引入了额外的条件控制机制,通过该机制可实现流畅且精准的首尾帧变换。

在训练阶段,团队还构建了专门用于首尾帧模式的训练数据,同时针对文本与视频编码模块、扩散变换模型模块采用了并行策略,这些策略提升了模型训练和生成效率,也保障了模型具备高分辨率视频生成的效果。

在推理阶段,为了在有限内存资源的条件下支持高清视频推理,万相首尾帧模型分别采用了模型切分策略以及序列并行策略,在确保推理效果无损的前提下,显著缩短了推理时间。

功能升级

基于该模型,用户可完成更复杂、更个性化的视频生成任务,可以实现同一主体的特效变化、不同场景的运镜控制等视频生成。

例如,上传相同位置不同时间段的两张外景图片,输入一段提示词,通义万相首尾帧生成模型即可生成一段四季交替变化或者昼夜变化的延时摄影效果视频;上传两张不同画面的场景,还可通过旋转、摇镜、推进等运镜控制衔接画面,在保证视频和预设图片一致性前提下,同时让视频拥有更丰富的镜头。

本站附开源地址:

Github:https://github.com/Wan-Video/Wan2.1

HuggingFace:https://huggingface.co/Wan-AI/Wan2.1-FLF2V-14B-720P

魔搭社区:https://www.modelscope.cn/models/Wan-AI/Wan2.1-FLF2V-14B-720P

直接体验入口:https://tongyi.aliyun.com/wanxiang/videoCreation

相关文章

-

业界首个,阿里通义万相“首尾帧生视频模型”开源

业界首个,阿里通义万相“首尾帧生视频模型”开源本站 4 月 17 日消息,阿里通义万相「首尾帧生视频模型」今日宣布开源,该模型参数量为 14B,号称是业界首个百亿参数规模的开源首尾帧视频模型。它可根据用户指定的开始和结束图片,生成一段能衔接首尾画

-

天猫魔屏 C3 投影仪发布:1080P、优酷内容终身会员,1599 元

天猫魔屏 C3 投影仪发布:1080P、优酷内容终身会员,1599 元本站 4 月 17 日消息,天猫魔屏 C3 投影仪今日上市,售价 1599 元。该投影仪主打优酷内容终身会员,支持 1080P 画质,配有 2GB + 32GB 存储、双 5W 喇叭。天猫魔屏 C3

-

优化小艺建议模块推荐策略,华为 MatePad 平板产品获鸿蒙 HarmonyOS NEXT 5.0.0.155 升级

优化小艺建议模块推荐策略,华为 MatePad 平板产品获鸿蒙 HarmonyOS NEXT 5.0.0.155 升级感谢本站网友 冀北疆南、Ruche_C、小谈家的猫、adong_a、与风、自信的眉毛 的线索投递! 本站 4 月 17 日消息,华为 MatePad 平板

-

美国当局关税政策背景下,消息称苹果开始在巴西组装 iPhone 16e 手机

美国当局关税政策背景下,消息称苹果开始在巴西组装 iPhone 16e 手机本站 4 月 18 日消息,据外媒 MacMagazine 报道,富士康正在悄悄调整苹果 iPhone 供应链布局,开始在巴西组装 iPhone 16e。据悉,相应巴西版 iPhone 16e 手机的

-

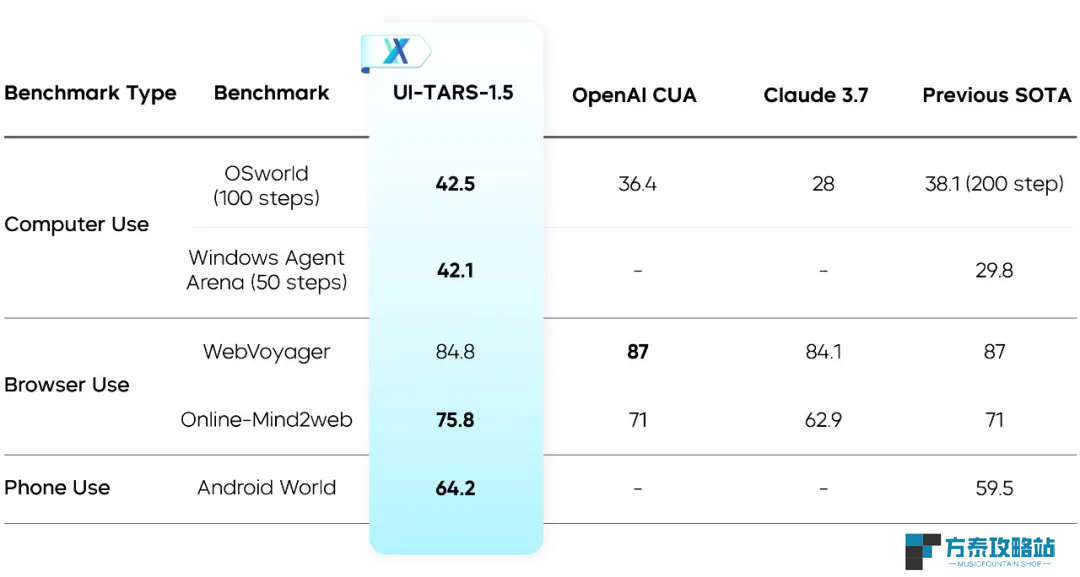

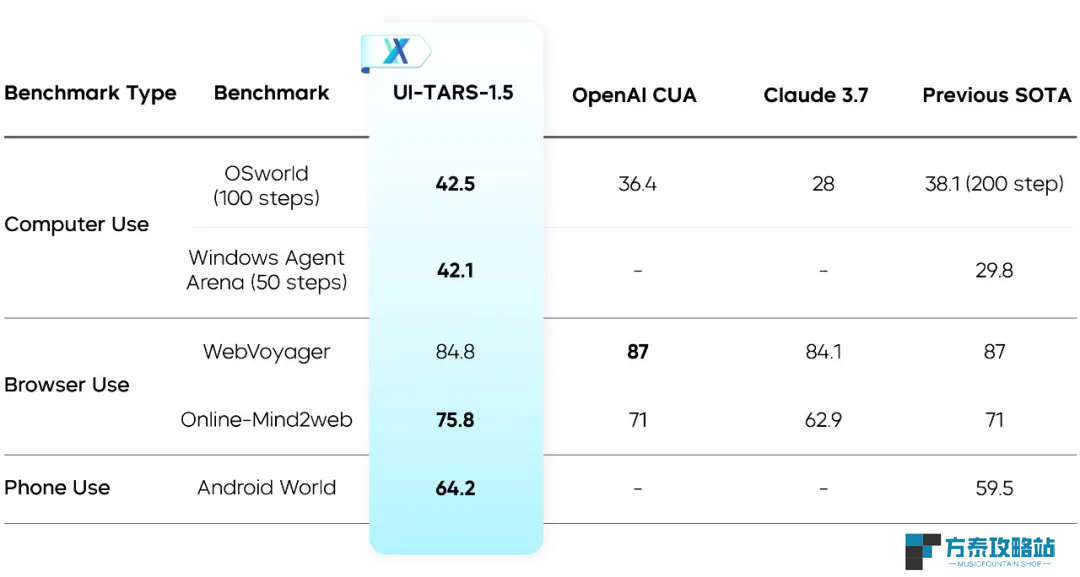

字节 Seed 开源 UI-TARS-1.5:基于视觉-语言模型构建的多模态智能体

字节 Seed 开源 UI-TARS-1.5:基于视觉-语言模型构建的多模态智能体本站 4 月 18 日消息,本站从豆包大模型团队获悉,UI-TARS-1 5 昨日正式发布并开源。这是一款基于视觉-语言模型构建的开源多模态智能体,能够在虚拟世界中高效执行各类任务。有关的链接如下:G

-

英特尔 CEO 陈立武精简领导团队,原网络芯片负责人 Sachin Katti 出任 CTO

本站 4 月 18 日消息,据路透社今日报道,英特尔新任首席执行官陈立武已着手精简管理架构,重要芯片部门今后将直接向他本人汇报。根据陈立武向员工发布的备忘录,英特尔已提拔网络芯片负责人 Sachin